- How To Fix Crawl Errors in Google Search Console

- lay-out van Crawl-fouten

- Sitefouten

- hoe vaak moet u controleren?

- Wat zijn DNS-fouten?

- Wat is hun belang?

- Hoe kunt u DNS-problemen oplossen?

- Wat is een serverfout?

- Wat is het belang van serverfouten?

- serverfouten oplossen

- Robots failure

- Wat is het belang van het falen van de Robot?

- hoe fix ik een fout in robots?

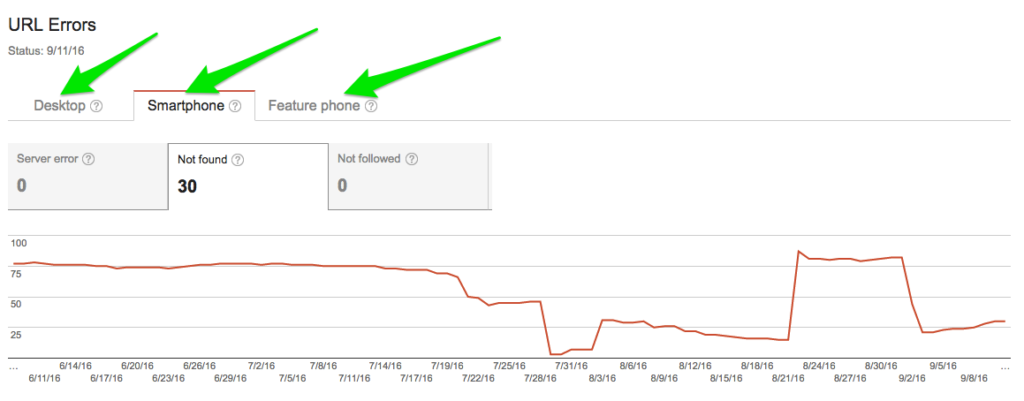

- URL-fouten

- Soft 404

- Wat is hun belang?

- Soft 404-fouten oplossen

- welk belang hebben zij?

- 404-fouten herstellen

- rol van toegang geweigerde fouten

- access denied-fouten herstellen

- serverfouten en Domain Name Systemfouten

- eindoordeel

How To Fix Crawl Errors in Google Search Console

in de afgelopen jaren heeft Google verschillende wijzigingen aangebracht in zijn Search Console, voorheen bekend als Google Webmaster Tools.

de reuzenzoekmachine heeft aanzienlijke hoeveelheden gegevens vrijgegeven die zeer nuttig zullen zijn voor de optimalisatie van zoekmachines.

aangezien we belangrijke zoekwoordgegevens met betrekking tot Google Analytics hebben verloren, hebben we geen andere optie dan afhankelijk te zijn van Search Console.

de meest prominente functies die niet bestonden in Google Webmaster Tools zijn Links naar uw Website en Zoekanalyse.

hoewel Google ‘ s tools ons misschien nooit volledig tevreden stellen, moeten we toegeven dat ze vaak waardevolle informatie vrijgeven.

de giant search engine heeft meer help docs en ondersteuningsbronnen gevonden om gebruikers van Search Console te helpen bij het vinden en repareren van fouten.

hoewel de opwinding die door de nieuwe ontwikkelingen wordt gegenereerd onvergelijkbaar kan zijn met de opwinding die wordt veroorzaakt door het creëren van 10x-content of het aangenaam kijken naar zoekwoorden die in ranglijsten springen, speelt dit deel van de zoekmachine-optimalisatie nog steeds een vitale rol.

Als u gebruik maakt van de epische visualisatie van Portent om te onderzoeken hoe stukjes en stukjes internetmarketing in elkaar passen, zult u ontdekken dat de vaststelling van crawl-fouten in de Google Search Console perfect past in de totale infrastructuur taart.

lay-out van Crawl-fouten

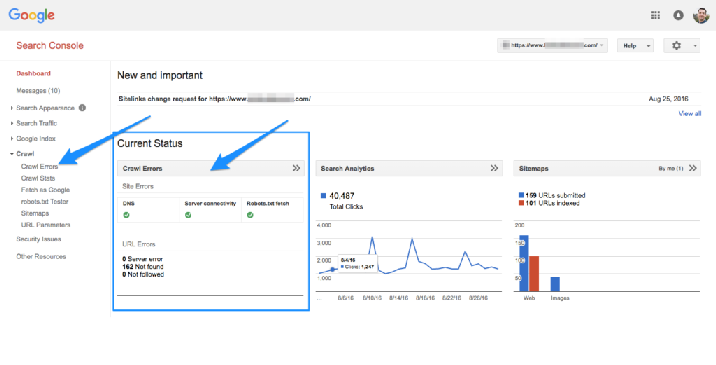

algemene lay-out van crawl-fouten binnen de Google Search Console heeft de afgelopen jaren een aanzienlijke evolutie doorgemaakt. Search Console is in grote lijnen ingedeeld in twee:

- URL-fouten

- Sitefouten

deze vorm van classificatie is zeer nuttig omdat de verschillen tussen fouten op paginaniveau en siteniveau verschillend zijn.

problemen op het niveau van de site kunnen zeer rampzalig zijn omdat ze in staat zijn om de algehele bruikbaarheid van uw website te beschadigen.

omgekeerd zijn URL-fouten minder rampzalig en minder urgent omdat ze alleen individuele webpagina ‘ s beïnvloeden.

Sitefouten

in principe zijn het fouten op hoog niveau die de site volledig kunnen beïnvloeden. Daarom moet je aandacht besteden aan hen.

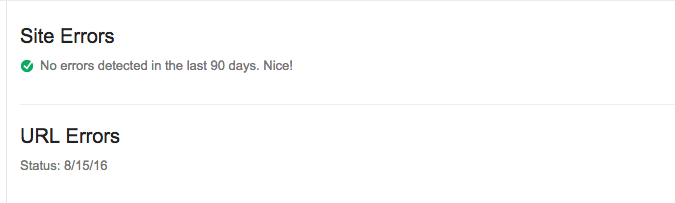

als u Crawl Errors dashboard bezoekt, zult u de fouten zien die uw website de afgelopen drie maanden hebben beïnvloed.

idealiter zou Google je een mooie score moeten geven. Het is zeldzaam voor de zoekmachine om uw site te valideren. Daarom, als je een mooie score te krijgen, weet gewoon dat je het doen van een geweldig werk.

hoe vaak moet u controleren?

idealiter moet u elke 24 uur op de aanwezigheid van fouten controleren. Er zullen meestal geen grote problemen zijn, maar je moet niet moe worden. Stel je de omvang van de schade die zal optreden als u niet regelmatig te controleren.

als het onmogelijk of moeilijk is om dagelijks op sitefouten te controleren, overweeg dan om uw website om de 90 dagen te onderzoeken om na te gaan of er zich tijdens de periode van 3 maanden problemen hebben voorgedaan en herstel de fouten dienovereenkomstig.

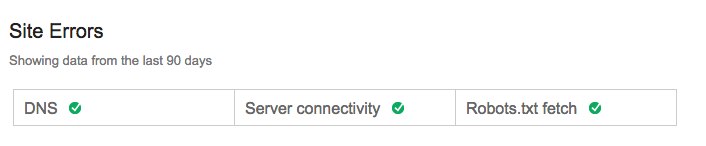

Locatiefouten kunnen grofweg worden ingedeeld in drie:

- DNS-fouten

- serverfouten

- Robots failure

Wat zijn DNS-fouten?

DNS is een acroniem voor Domain Name System. Ze zijn de meest voorkomende fouten en zijn meestal de eerste om websites te beïnvloeden.

als Googlebot problemen ondervindt met betrekking tot DNS, zal uw site geen verbinding kunnen maken met Googlebot via een DNS lookup of Time-Out probleem.

Wat is hun belang?

DNS-problemen spelen een zeer belangrijke rol omdat het de eerste stap is die moet worden genomen wanneer u toegang wilt krijgen tot uw site.

u moet drastische en stevige actie ondernemen wanneer u DNS-problemen begint te ervaren die de verbinding tussen uw site en de gigantische zoekmachine verhinderen.

Hoe kunt u DNS-problemen oplossen?

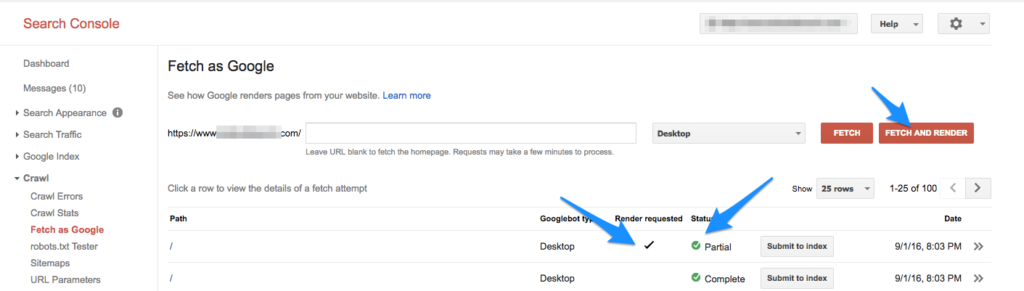

Google raadt het gebruik aan van een tool genaamd Fetch als Google om erachter te komen hoe Googlebot op uw webpagina ‘ s kruipt.

Als u alleen een DNS-verbindingsstatus nodig hebt,kunt u als Google ophalen zonder noodzakelijkerwijs te renderen, vooral als u snelle resultaten wilt.

neem contact op met uw service provider van Domain Name System.

als de zoekmachine niet in staat is om uw pagina correct op te halen en te renderen, dan moet u meer actie ondernemen. Vraag uw DNS-serviceprovider om erachter te komen waar het probleem is.

Controleer of de foutcode op uw server 500 of 404 fout is. Uw server moet een serverfout tonen of een fout niet gevonden (respectievelijk 500 en 404).

wat de nauwkeurigheid betreft, zijn de twee bovengenoemde codes beter dan het ervaren van een DNS-fout.

Andere hulpmiddelen die u kunt gebruiken om DNS-problemen te controleren en op te lossen zijn Websniffer. net en ISUP.me ook.

Wat is een serverfout?

een serverfout is die welke optreedt wanneer de responstijd van uw server extreem lang is, wat leidt tot een time-out van het verzoek.

bent u zich ervan bewust dat de Googlebot die uw website doorzoekt slechts een beperkte tijd kan wachten wanneer het nodig is om uw site te laden.

als de responstijd van uw server erg lang is, zal Googlebot het gewoon opgeven.

er is een verschil tussen DNS-fouten en serverfouten. In het eerste geval, Googlebot ervaart moeite met het vinden van uw URL, met dank aan DNS problemen.

in het tweede geval voorkomen problemen met de Googlebot-server dat Googlebot de webpagina kan laden, ook al kan het verbinding maken met de website.

Wat is het belang van serverfouten?

u moet onmiddellijk actie ondernemen als u ontdekt dat uw site serverfouten vertoont. Dit komt omdat ze rampzalige gevolgen kunnen hebben op uw site.

de fouten maken het onmogelijk voor Googlebot om te crawlen. Als gevolg daarvan geeft het consequent op na een bepaalde periode van tijd.

serverfouten oplossen

Google raadt het gebruik van Fetch als Google aan om erachter te komen of Googlebot in staat is uw site te crawlen.

als de tool geen problemen met uw homepage aangeeft, kunt u er veilig vanuit gaan dat de zoekmachine in staat is om toegang te krijgen tot uw website.

er zijn verschillende soorten serverfouten. Ze omvatten; time-out, geen antwoord, afgekapt headers, connect time-out, verbinding reset, verbinding mislukt, afgekapt antwoord en verbinding geweigerd, onder andere problemen.

Ontdek het specifieke type probleem dat van invloed is op uw website voordat u het probeert op te lossen.

Robots failure

deze fout treedt op wanneer Google de robots van uw site niet kan ophalen.txt-bestand.

het zal u verbazen dat het bestand alleen nodig is als u wilt dat de zoekmachine bepaalde pagina ‘ s overslaat tijdens het crawlen van uw site.

u hebt het bestand alleen nodig als uw website inhoud bevat die niet geïndexeerd mag worden door Google of andere zoekmachines.

Wat is het belang van het falen van de Robot?

er hoeft geen dringende actie te worden ondernomen als uw site nog steeds klein en zeer statisch is. Bovendien hoeft u zich geen zorgen te maken als u geen nieuwe pagina ‘ s hebt toegevoegd of als er in het recente verleden geen belangrijke wijzigingen zijn aangebracht.

omgekeerd, als uw website bijna elke dag nieuwe inhoud publiceert, moet het probleem zo snel mogelijk worden opgelost.

dit is omdat als Goglebot het eerder genoemde bestand niet kan laden, het uw site niet zal crawlen. Als gevolg hiervan worden eventuele wijzigingen of pagina ‘ s die zijn toegevoegd niet geïndexeerd.

hoe fix ik een fout in robots?

om het probleem op te lossen, moet u eerst de juiste configuratie van de robots nagaan.txt-bestand.

bevestig de pagina ’s die u wilt dat Googlebot tijdens het kruipen overslaat, omdat het standaard alle andere pagina’ s zal doorzoeken.

bovendien moet u controleren of de clausule ‘niet toestaan’ bestaat. Zorg ervoor dat het helemaal niet bestaat.

als uw bestand geen problemen vertoont, maar u ondervindt nog steeds problemen, gebruik dan een hulpprogramma dat bekend staat als server-header checker om erachter te komen of het bestand een 404-of 200-fout weergeeft.

URL-fouten

er is een groot verschil tussen sitefouten en URL-fouten. Terwijl de eerste kan invloed hebben op de hele website, de laatste kan alleen invloed hebben op bepaalde pagina ‘ s.

veel eigenaren van websites hebben ervaren problemen veroorzaakt door URL-fouten, en de problemen maken ze soms bezorgd.

echter, als u eigenaar bent van een site of sites, hoeft u niet te flippen. Vergeet niet dat Google meestal rangschikt fouten, afhankelijk van de schade die ze kunnen veroorzaken.

bovendien kunnen de fouten automatisch worden opgelost

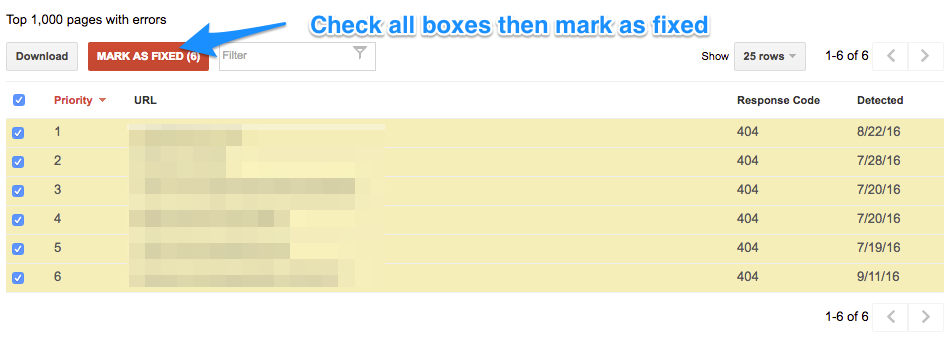

Als u in het recente verleden aanzienlijke wijzigingen aan uw website hebt aangebracht met het doel fouten te herstellen, of als u er sterk van overtuigd bent dat de meeste fouten niet meer voorkomen, waarom markeert u dan niet alle opgeloste fouten en houdt u ze regelmatig in de gaten?

het voordeel van het nemen van deze actie is, de fouten zal stoppen verschijnen op het dashboard, hoewel de zoekmachine zal houden onthullen ze wanneer Googlebot kruipt uw site.

als de URL-fouten correct zijn opgelost, zullen ze niet meer verschijnen. In het geval dat ze verschijnen, moet u ze op te lossen binnen de kortst mogelijke tijd.

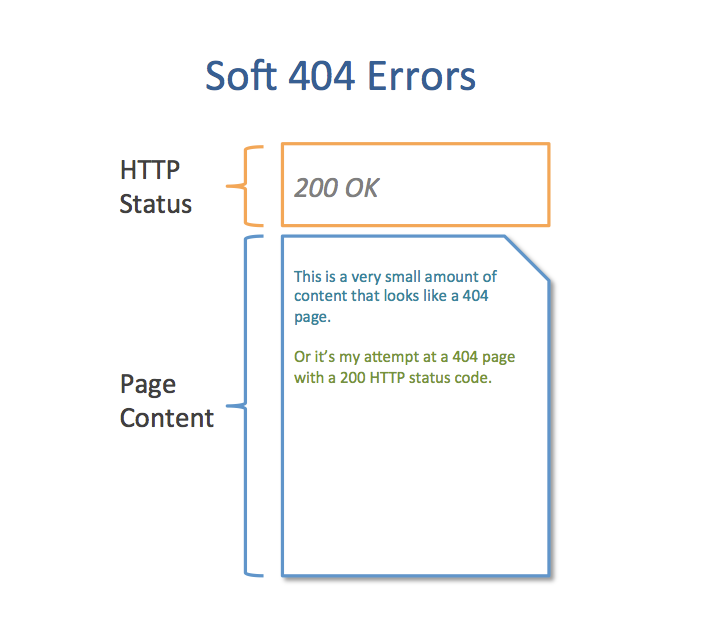

Soft 404

deze fout treedt op wanneer een webpagina wordt aangegeven als gevonden, in plaats van als niet gevonden.

bent u zich ervan bewust dat een 404 pagina eruit kan zien als een echte niet gevonden Pagina, zelfs als dat niet het geval is?

het voor de gebruiker zichtbare element van een typische 404-pagina is de inhoud van de pagina. Het weergegeven bericht moet gebruikers informeren over het verdwijnen van de pagina.

Website-eigenaren meestal helpen bezoekers van de site door gebruik te maken van interessante 404 reacties of lijst van weblinks die ze kunnen bezoeken.

Wat is hun belang?

in het geval dat de pagina ‘ s vermeld als 404 fouten zijn niet erg belangrijk, er is geen noodzaak voor u om ze dringend te repareren.

echter, als de pagina ‘ s vermeld als 404 fouten zijn zeer belangrijk omdat ze productcategorieën bevatten, adres van uw bedrijf of informatie over de betaling van goederen of diensten, dan zal het nodig zijn om het probleem zo snel mogelijk op te lossen.

Soft 404-fouten oplossen

als de pagina ‘ s niet meer bestaan:

- zorg ervoor dat de server-header-response 410 of 404 is. Het zou geen 200 moeten zijn.

- Redirect alle oude webpagina ’s naar relevante pagina’ s binnen de site.

- vermijd het omleiden van grote volumes dode pagina ‘ s naar de homepage van de website. In plaats daarvan, direct ze naar soortgelijke pagina ‘ s die u geschikt vindt.

- 404 fouten

dit type fout geeft aan dat Googlebot probeerde te crawlen op een niet-bestaande pagina. Het geeft de fout aan wanneer de niet-bestaande pagina is gekoppeld aan bestaande webpagina ‘ s of sites.

Google geeft duidelijk aan dat 404-fouten geen effect hebben op rankings. Om die reden kunt u de fouten negeren.

welk belang hebben zij?

Als pagina ‘ s met zeer nuttige informatie 404-fouten weergeven, moet onmiddellijk actie worden ondernomen. Echter, als de webpagina verdwenen, maar het bevatte geen nuttige informatie, dan hoeft u zich geen zorgen te maken.

404-fouten herstellen

de volgende stappen moeten worden genomen als uw webpagina ‘ s 404-fouten weergeven:

- zorg ervoor dat het publiceren van de webpagina wordt gedaan vanaf uw CMS (content management system). Het mag niet worden verwijderd of gepubliceerd in conceptmodus.

- Controleer of de fout-URL geen variatie is, maar een correcte pagina.

- Zoek uit of de fout verschijnt op de versies http versus niet-http en www versus niet-www van uw website.

- zorg ervoor dat u 301-redirect de betreffende pagina naar een verwante pagina die u het meest geschikt acht.

- Toegang geweigerd fouten

dit bericht is een indicatie dat Googlebot de webpagina niet kan doorzoeken. De fouten te voorkomen dat het kruipen op de volgende manieren:

- wanneer u gebruikers vraagt om eerst in te loggen voordat u een URL of,

- Robots.txt-bestand voorkomt dat Googlebot specifieke sites of,

- uw host blokkeert Googlebot, of severs vraagt gebruikers om te bevestigen door proxy.

rol van toegang geweigerde fouten

Als u wilt dat Googlebot de geblokkeerde pagina ‘ s crawl, dan moet u de fouten binnen de kortste tijd repareren.

echter, als u niet wilt dat het de geblokkeerde pagina ‘ s crawl, gewoon negeren de foutmeldingen.

access denied-fouten herstellen

- verwijder de aanmeldingsvereiste van pagina ‘ s waarop Googlebot moet kruipen.

- Zoek uit of pagina ‘ s op robots worden weergegeven.txt-bestand worden verondersteld te worden geblokkeerd van zowel indexeren en kruipen.

- gebruik een tool die robots wordt genoemd.txt tester om waarschuwingen te vinden en tests uit te voeren op individuele URL ‘ s.

- gebruik Fetch als Googleom het uiterlijk van uw site te testen op Googlebot.

- gebruik Screaming Frog om uw website te scannen.

- niet gevolgd fouten

deze fouten treden op wanneer Google problemen ondervindt met onder andere Flash, redirects en Javascript.

u moet zich zorgen maken over deze fouten wanneer ze optreden op URL ‘ s met hoge prioriteit.

als de problemen ontstaan door url ‘ s die inactief zijn geworden, of voortvloeien uit niet-geïndexeerde parameters, dan is er geen reden om u zorgen te maken.

om de fouten te herstellen, gebruik maken van Fetch als Google of lyn Tekstbrowser om de site te onderzoeken. Als u belangrijke inhoud niet ziet of de pagina ‘ s worden geladen, zou u hebben ontdekt waar het probleem ligt.

voor niet-gevolgde problemen met omleidingen, volg de onderstaande stappen:

- Zoek uit of er redirect ketens zijn.

- de architectuur van de website bijwerken.

- verwijder omgeleide URL ‘ s in de sitemap.

er zijn andere tools die u ook kunt gebruiken om deze fouten te herstellen. Ze zijn Screaming Frog zoekmachine optimalisatie Spider, Raven-Tools Site-Auditor en MOZ Professional Site Crawl.

serverfouten en Domain Name Systemfouten

Google classificeert nog steeds DNS-en serverfouten onder de URL-foutenparaplu. Dit is vooral omdat de giant search engine wil dat u de fouten te detecteren en op te lossen op dezelfde manier je zou zorgen voor de hierboven genoemde fouten.

zie om deze reden bovenstaande informatie.

eindoordeel

sommige problemen met zoekmachineoptimalisatie kunnen zeer saai zijn, vooral als ze technisch van aard zijn.

het kan voor iemand heel moeilijk zijn om URL-fouten te inspecteren die inconsequent lijken.

aan de andere kant wil niemand in paniek raken als gevolg van het ontdekken van talrijke fouten op hun website.

echter, als u deze gewoonte verwerft, zult u de capaciteit hebben om op de juiste manier op deze fouten te reageren. Als een zaak van de feiten, de ervaring zal u in staat om de fouten met minimale mentale inspanning te behandelen.

Google heeft veel informatie over de Zoekconsole. Toegang tot de informatie en neem de tijd om door te gaan.

de formidabele zoekmachine biedt uiterst effectieve en efficiënte tools voor het identificeren en herstellen van fouten. Als u de fouten op te lossen, zal er grote verbetering in uw site rankings.

uw site kan zelfs verschijnen op de eerste pagina van de zoekresultaten van Google.

bovendien zal het oplossen van de fouten mensen die uw site bezoeken in staat stellen een betere surfervaring te hebben en ook de conversieratio ‘ s te verbeteren. Waar wacht je op?